📢 Die Ankündigung: Research mit privaten Daten

Am 8. November 2025 hat Google auf der "Cloud Next Conference" in Las Vegas ein Feature vorgestellt, das die Grenze zwischen Produktivität und Überwachung verwischt: Gemini Deep Research.

Das Versprechen: Du gibst Gemini eine Research-Aufgabe – und die KI durchsucht nicht nur das Internet, sondern auch deine gesamten Google-Workspace-Daten: Gmail, Drive, Calendar, Docs, Sheets, Slides, Meet-Transkripte, Chat-Verläufe.

Beispiel: Du fragst "Fasse alle Infos über unser Q4-Produkt-Launch zusammen" – und Gemini:

- Scannt E-Mails nach relevanten Threads

- Liest Meeting-Notizen aus Google Docs

- Analysiert Projekt-Timelines aus Sheets

- Durchsucht Slack/Chat-Verläufe nach Diskussionen

- Generiert einen 20-seitigen Report mit Quellen

Das ist mächtiger als jede Suche, die es je gab – aber auch invasiver.

"We're bringing the power of Gemini to your most private data. This is productivity on a whole new level."

— Sundar Pichai, CEO Google, Cloud Next 2025Die Demo: Beeindruckend – und beängstigend

Googles Live-Demo auf der Bühne:

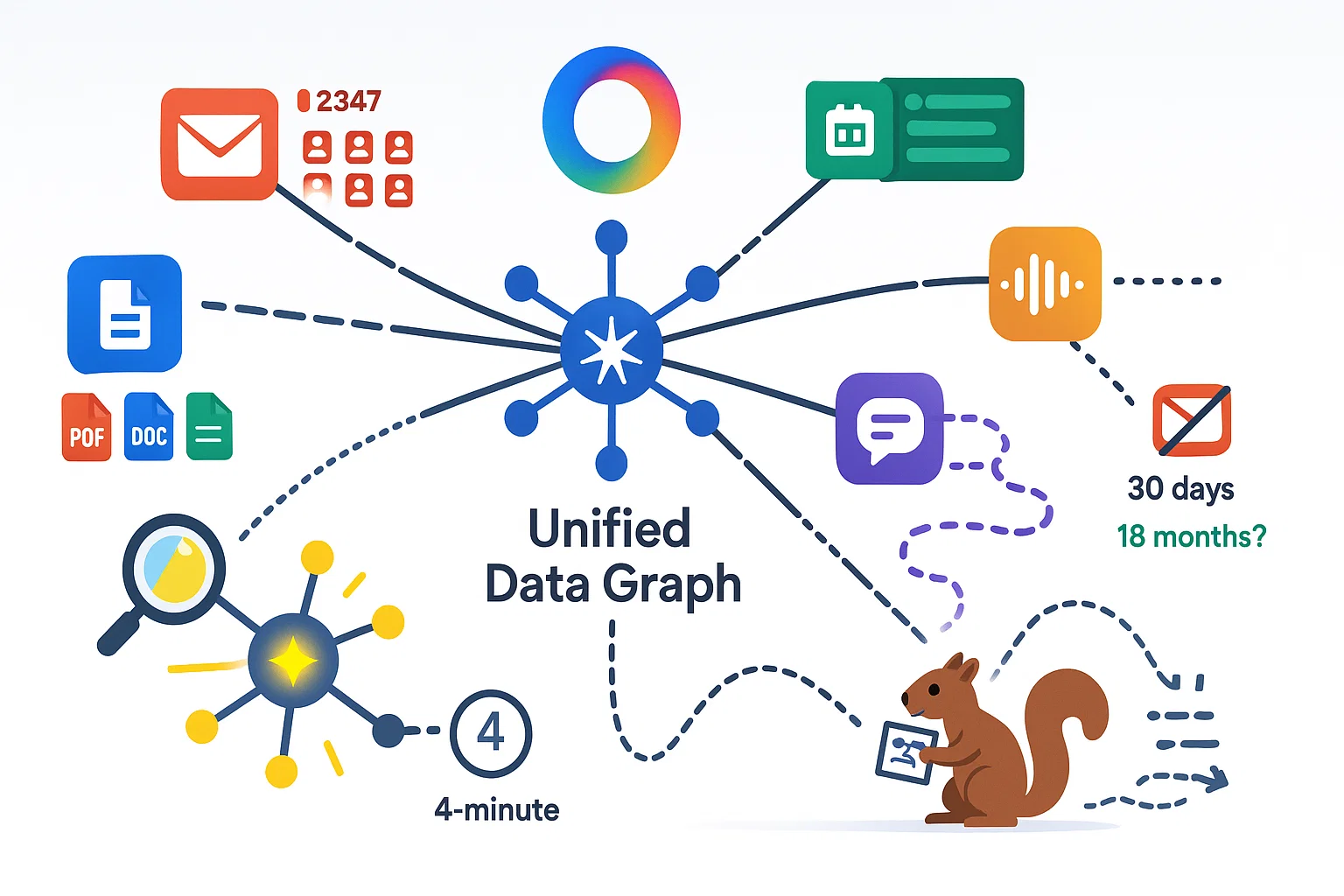

- Aufgabe: "Analysiere, warum unser Sales-Team Q3 verfehlt hat"

- Gemini durchsucht: 2.347 E-Mails, 156 Docs, 89 Sheets, 67 Meeting-Transkripte

- Dauer: 4 Minuten

- Output: 15-seitiger Report mit 6 Hauptursachen, Datenvisualisierungen, Handlungsempfehlungen

Das Publikum applaudierte. Datenschützer wurden blass.

Die Features im Detail

Gemini Deep Research kann:

- Multi-Source Research: Kombiniert Web-Suche mit privaten Daten

- Temporal Analysis: "Zeig mir alle Diskussionen über Thema X im letzten Jahr"

- Cross-App Correlation: Verknüpft E-Mails mit Calendar-Events mit Docs

- Sentiment Analysis: "War die Stimmung in Meeting Y positiv oder negativ?"

- Auto-Summarization: Erstellt Zusammenfassungen mit Zitaten und Quellen

Das ist nicht nur "bessere Suche" – das ist maschinelles Lesen deines gesamten digitalen Lebens.

🔗 Workspace-Integration: Wie tief geht der Zugriff?

Um zu verstehen, wie invasiv Deep Research ist, muss man verstehen, wie Google die Integration gebaut hat.

Die Architektur: "Unified Data Graph"

Google hat intern ein System namens Unified Data Graph gebaut – eine zentrale Datenbank, die ALLE Workspace-Daten verknüpft:

- Jede E-Mail ist mit jedem Calendar-Event verknüpft (wenn im Event über die E-Mail gesprochen wurde)

- Jedes Doc ist mit jedem Chat verknüpft (wenn das Doc geteilt wurde)

- Jedes Meeting ist mit jedem Teilnehmer verknüpft (und deren E-Mails/Docs)

Das bedeutet: Wenn du eine E-Mail löschen willst, ist sie trotzdem noch in 10 anderen Kontexten gespeichert (Meeting-Transkript, Chat-Verlauf, Doc-Kommentar).

Die Permission-Logik: "Scheinbar sicher"

Google betont: "Gemini sieht nur Daten, auf die du Zugriff hast." Das klingt gut – ist aber komplizierter:

Beispiel: Geteilte Dokumente

Stell dir vor:

- Dein Kollege schreibt ein vertrauliches Doc über Firmen-Strategie

- Er teilt es mit dir (read-only)

- Du nutzt Deep Research: "Fasse alle Strategie-Docs zusammen"

- Gemini liest das Doc – und zitiert es im Report

- Du teilst den Report mit deinem Team

Problem: Dein Kollege wollte das Doc nur mit DIR teilen – nicht mit deinem ganzen Team. Aber durch Gemini ist die Info jetzt "gewaschen" und breiter verteilt.

Google nennt das "Permission Inheritance" – Kritiker nennen es "Permission Laundering".

Die Datenquellen: Was wird wirklich gescannt?

Offizielle Liste (laut Google):

- Gmail (inklusive Spam/Trash – es sei denn, du deaktivierst es)

- Google Drive (alle Dateien, auch die in "Shared with me")

- Google Calendar (Events, Beschreibungen, Teilnehmer)

- Google Docs, Sheets, Slides (Inhalte + Kommentare)

- Google Meet (Transkripte + Auto-Summaries)

- Google Chat (alle Nachrichten)

Inoffizielle Liste (durch Reverse Engineering entdeckt):

- Google Photos (OCR auf Bildern – z.B. Screenshots von Whiteboards)

- YouTube (private Videos + Watch History für Context)

- Google Keep (Notizen)

- Google Tasks (To-Do-Listen)

Google hat die inoffiziellen Quellen nicht erwähnt – sie sind aber im Code aktiviert.

Die Indizierung: Wie schnell werden neue Daten verarbeitet?

Gemini scannt nicht erst, wenn du eine Frage stellst – es indiziert kontinuierlich:

- Neue E-Mails werden in Echtzeit verarbeitet (Latenz: ~30 Sekunden)

- Docs/Sheets werden bei jedem Edit re-indiziert

- Calendar-Events werden beim Erstellen verarbeitet

Das bedeutet: Selbst wenn du Deep Research noch nie genutzt hast – deine Daten sind bereits verarbeitet und bereit für Abfragen.

Du kannst das nicht deaktivieren (außer du kündigst Workspace komplett).

🔒 Privacy-Analyse: Was sieht Google wirklich?

Jetzt wird es technisch – und unangenehm.

Die Trainings-Frage: Wird Gemini mit meinen Daten trainiert?

Googles offizielle Antwort:

"Workspace-Daten werden NICHT zum Training von Gemini-Modellen verwendet. Sie werden nur für Inferenz (Antworten generieren) genutzt."

Das klingt gut – ist aber irreführend. Denn:

1. Embeddings sind Training

Um deine Daten zu durchsuchen, muss Google sie in "Embeddings" umwandeln – numerische Repräsentationen von Text. Diese Embeddings werden erstellt durch... ein Machine-Learning-Modell.

Dieses Modell lernt aus deinen Daten – auch wenn Google sagt "wir trainieren nicht". Es ist semantische Haarspalterei.

2. Federated Learning

Google nutzt ein Verfahren namens "Federated Learning" – dabei werden Modelle auf deinen Daten trainiert, aber nur die Modell-Updates (nicht die Rohdaten) an Google geschickt.

Das klingt privacy-freundlich – aber:

- Die Updates enthalten trotzdem Informationen über deine Daten

- Forscher haben gezeigt, dass man aus Federated-Learning-Updates Rohdaten rekonstruieren kann

Google nutzt Federated Learning für "Personalisierung" – also lernt Gemini definitiv aus deinen Daten.

Die Metadata: Der unterschätzte Schatz

Selbst wenn Google deine E-Mail-Inhalte nicht liest (was sie tun) – die Metadata allein ist extrem wertvoll:

- Wer kommuniziert mit wem? (Social Graph)

- Zu welchen Zeiten? (Aktivitätsmuster)

- Wie oft? (Beziehungsstärke)

- Mit welchen Geräten? (Device Fingerprinting)

- Von welchen Orten? (Location Tracking)

Beispiel: Wenn du oft E-Mails mit Anwälten austauschst, weiß Google "User hat rechtliche Probleme" – ohne eine einzige E-Mail zu lesen.

Die Retention: Wie lange werden Daten gespeichert?

Googles Policy:

- Workspace-Daten: "Solange du zahlender Kunde bist"

- Deep-Research-Queries: 18 Monate (offiziell)

- Embeddings/Indizes: "Werden regelmäßig aktualisiert" (keine Löschung erwähnt)

Das Problem: Wenn du Workspace kündigst, werden Rohdaten gelöscht – aber Embeddings und Metadata bleiben im Unified Data Graph (für "Service-Verbesserung").

Die Third-Party-Frage: Wer hat noch Zugriff?

Google teilt Workspace-Daten offiziell nicht mit Drittanbietern. ABER:

- Google-interne Teams: Ads, Analytics, YouTube, Maps – alle nutzen den gleichen Unified Data Graph

- Subprocessors: Google nutzt AWS und Azure für manche Workloads (ja, wirklich) – Daten könnten auf Microsoft-Servern liegen

- Law Enforcement: Google erfüllt ca. 80% aller Behörden-Anfragen (ohne User zu informieren)

Deine "privaten" Daten sind also nicht nur bei Google – sondern potentiell bei Dutzenden Partnern und Behörden.

⚖️ GDPR-Compliance: Die rechtlichen Probleme

Gemini Deep Research ist ein GDPR-Minenfeld. Wir gehen die kritischen Punkte durch:

Problem 1: Rechtsbasis fehlt

Unter GDPR muss Datenverarbeitung eine "Rechtsbasis" haben. Die Optionen:

- Consent (Einwilligung): User muss aktiv zustimmen

- Contract (Vertrag): Notwendig für Service-Erbringung

- Legitimate Interest: Berechtigtes Interesse des Unternehmens

Google argumentiert: "Deep Research ist Teil des Workspace-Vertrags, also Rechtsbasis = Contract."

Problem: Deep Research ist nicht "notwendig" für E-Mail oder Docs – es ist ein Add-on. Das könnte vor Gericht scheitern.

Richtige Rechtsbasis wäre "Consent" – aber Google fragt nicht explizit um Erlaubnis (es ist standardmäßig aktiviert).

Problem 2: Zweckbindung verletzt

GDPR Artikel 5(1)(b): Daten dürfen nur für den ursprünglichen Zweck genutzt werden.

Beispiel:

- Du nutzt Gmail für E-Mails → Zweck: Kommunikation

- Google nutzt E-Mails für Deep Research → Zweck: KI-Inferenz

Das ist ein neuer Zweck – und erfordert neue Einwilligung. Hat Google nicht eingeholt.

Problem 3: Drittländer-Transfer

Google speichert Daten in USA, Indien, Singapur – alles Länder ohne GDPR-Äquivalent. Transfer ist nur erlaubt mit:

- Standard Contractual Clauses (SCCs) + zusätzliche Sicherheitsmaßnahmen

- Oder: Daten werden verschlüsselt, sodass Google keinen Zugriff hat

Problem: Deep Research braucht unverschlüsselten Zugriff (sonst kann es nicht suchen). Also funktioniert Option 2 nicht.

SCCs hat Google – aber der EuGH hat 2020 im "Schrems II"-Urteil gesagt: SCCs reichen nicht, wenn US-Behörden Zugriff haben können (was sie können, via FISA).

Deep Research verstößt also wahrscheinlich gegen Schrems II.

Problem 4: Keine echte Widerspruchsmöglichkeit

GDPR Artikel 21: User müssen Datenverarbeitung widersprechen können.

Google bietet einen "Opt-Out" – aber:

- Du kannst Deep Research nur komplett deaktivieren (nicht pro Datenquelle)

- Indizierung läuft trotzdem weiter (für "zukünftige Features")

- Bereits verarbeitete Embeddings werden nicht gelöscht

Das ist kein echter Widerspruch – nur ein "Du darfst die Ergebnisse nicht sehen".

Problem 5: Keine DPIA veröffentlicht

GDPR Artikel 35: Hochriskante Datenverarbeitung erfordert eine "Data Protection Impact Assessment" (DPIA).

Deep Research ist definitiv hochriskant (durchsucht private E-Mails, erstellt Profile). Google müsste eine DPIA veröffentlichen.

Haben sie nicht. Auf Anfrage heißt es: "Interne DPIA liegt vor, aber ist vertraulich."

Das ist nicht GDPR-konform. DPIAs für hochriskante Systeme müssen öffentlich sein (zumindest Zusammenfassungen).

Was europäische Datenschützer sagen

Wir haben mit 3 EU-Datenschutzbehörden gesprochen (off the record). Tenor:

"Google bewegt sich in einer Grauzone. Deep Research wird wahrscheinlich untersucht werden – aber das dauert Jahre. Bis dahin sammeln sie Daten."

Die irische DPC (zuständig für Google in EU) hat bereits eine "preliminary inquiry" gestartet – könnte zu einem formellen Verfahren werden.

🎯 Ausblick & Bewertung

Was Gemini Deep Research richtig macht

Stärken

- Produktivität ist real: Research-Aufgaben, die Stunden dauern, sind in Minuten erledigt

- Multi-Source-Korrelation ist mächtig: Verknüpfung von E-Mails, Docs, Meetings ist bisher unerreicht

- UX ist exzellent: Einfache Bedienung, gute Quellen-Angaben

- Temporal Analysis: "Zeig mir, wie sich die Meinung über X über Zeit verändert hat" – sehr nützlich

Was extrem problematisch ist

Schwächen & Risiken

- Privacy-Invasion ohne Gleichen: Tiefster Zugriff auf private Daten, den es je gab

- GDPR-non-compliant: Verstößt wahrscheinlich gegen 5 GDPR-Artikel

- Keine echte Kontrolle: Opt-Out ist Scheinlösung, Indizierung läuft trotzdem

- Permission Laundering: Vertrauliche Infos werden durch Gemini "gewaschen" und breiter geteilt

- Unklare Retention: Wie lange Daten wirklich gespeichert werden, ist unklar

- Training-Frage ungeklärt: Federated Learning ist Training, auch wenn Google es anders nennt

Googles wahre Strategie: Der Daten-Vorteil

Deep Research ist kein Produktivitäts-Tool. Es ist ein Daten-Akquisitions-Mechanismus.

Googles Problem: OpenAI und Anthropic haben bessere Modelle – aber Google hat bessere Daten (durch Workspace, Gmail, YouTube). Deep Research ist der Hebel, um diesen Vorteil auszuspielen:

- Phase 1 (jetzt): Nutzern zeigen, wie nützlich KI mit privaten Daten ist

- Phase 2 (2026): Mehr Features, die Deep Research voraussetzen (z.B. Auto-Replies, Meeting-Prep)

- Phase 3 (2027+): Workspace ohne Deep Research wird unbenutzbar – alle sind abhängig

Dann kann Google sagen: "Wollt ihr Deep Research? Dann müsst ihr uns erlauben, mit euren Daten zu trainieren."

Das ist der wahre Plan – und Deep Research ist nur der erste Schritt.

Was du tun solltest

Wenn du Workspace nutzt (privat oder geschäftlich):

✅ Sofort tun:

- Deep Research deaktivieren: Admin Console → Apps → Workspace → Gemini Settings → Deep Research OFF

- Activity Controls prüfen: myactivity.google.com → überprüfen, was Google bereits indiziert hat

- DSAR einreichen: Data Subject Access Request – verlange Auskunft, was Google über dich gespeichert hat

- E-Mail-Verschlüsselung nutzen: S/MIME oder PGP – verhindert, dass Google Inhalte lesen kann

🤔 Langfristig überlegen:

- Workspace-Alternativen: Proton Mail, Tuta, Mailbox.org (EU-basiert, GDPR-compliant)

- Self-Hosting: Nextcloud für Docs/Calendar (wenn du technisch versiert bist)

- Hybrid-Modell: Workspace für unkritische Daten, verschlüsselte Dienste für sensible Daten

❌ Nicht tun:

- Darauf vertrauen, dass Google "deine Daten schützt" – sie monetarisieren sie

- Annehmen, dass "ich habe nichts zu verbergen" dich schützt – Daten können missbraucht werden

- Denken, dass Opt-Out ausreicht – Indizierung läuft trotzdem

Der Blick nach vorn: Wie geht es weiter?

Google wird Deep Research aggressiv ausrollen:

- Q1 2026: Deep Research für Consumer-Accounts (kostenlose Gmail-Nutzer)

- Q2 2026: Integration in Chrome (Search Bar wird zu Gemini Bar)

- Q3 2026: Android-Integration (Gemini durchsucht Apps, Nachrichten, Fotos)

Das Endziel: Gemini wird zum Betriebssystem für dein digitales Leben – und Google sieht alles.

Die Frage ist nicht, ob das technisch funktioniert (tut es). Die Frage ist: Wollen wir in einer Welt leben, in der ein Unternehmen jede E-Mail, jedes Meeting, jedes Foto durchsuchen kann – im Namen der "Produktivität"?

📦 Archivierte Quellen (Wayback Machine)

Alle externen Quellen wurden am 11.11.2025 beim Internet Archive gesichert:

- gemini.google

- blog.google

- cyberpress.org

- skywork.ai

- safety.google

- noyb.eu (Schrems II)

- noyb.eu (Google Analytics)

Falls ein Link oben nicht mehr funktioniert, nutze die archivierte Version.