🎯 Die Kernmeldung: Doppelstrategie auf zwei Ebenen

Google hat eine koordinierte Strategie zur Etablierung von Gemini gestartet, die gleichzeitig Entwickler und Endnutzer adressiert:

- Front 1 (Entwickler): Das neue File Search Tool in der Gemini API – ein vollständig verwaltetes RAG-System mit disruptivem Preismodell.

- Front 2 (Consumer): Ein milliardenschwerer Lizenzdeal, der Gemini zur Kern-Engine von Apples neuem Siri macht.

👨💻 Front 1: Die Entwickler-Front (File Search Tool)

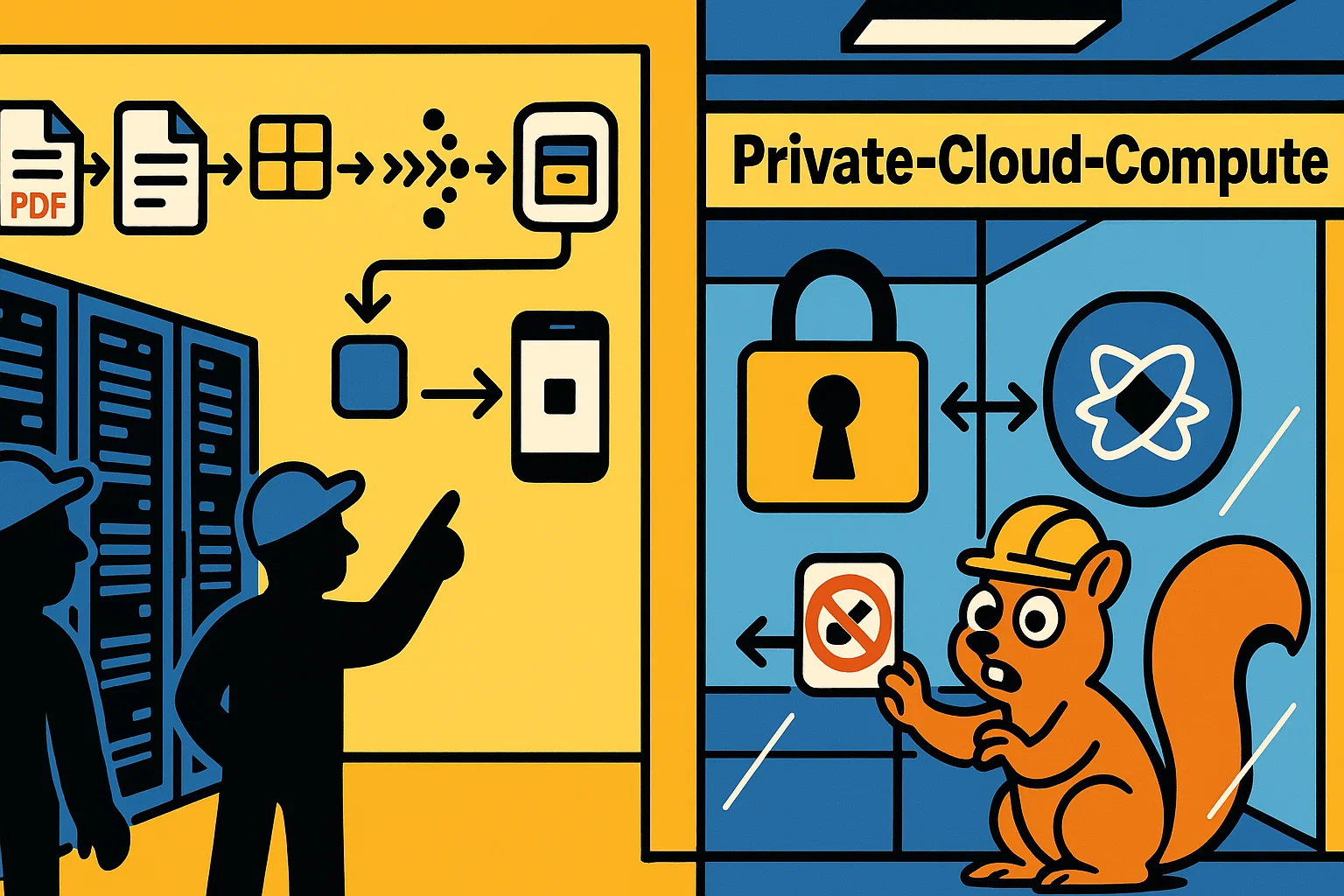

Google hat das „File Search Tool" für die Gemini API vorgestellt. Technisch ist dies ein vollständig verwaltetes RAG-System (Retrieval-Augmented Generation).

Das Problem, das RAG löst:

Wie bindet man eigene Daten (PDFs, Code, Dokumente) in ein KI-Modell ein? Bisher ist dieser Prozess komplex:

- Daten hochladen und speichern

- In sinnvolle Blöcke zerlegen („Chunking")

- In Vektoren umwandeln („Embedding")

- Semantische Suche implementieren

- Relevante Teile als Kontext ins Modell injizieren

Googles Lösung:

Das File Search Tool abstrahiert den gesamten Prozess. Entwickler laden einfach ihre Dateien hoch – Google übernimmt automatisch:

- Speicherung

- Chunking

- Embedding (mit gemini-embedding-001)

- Kontext-Injektion in den Prompt

Unterstützte Formate: PDF, DOCX, Code-Dateien, TXT, und mehr. Es ist eine echte „Plug-and-Play"-Lösung für Wissensdatenbanken.

Der strategische Kern: Das Preismodell

• Speicherung der Dateien: Kostenlos

• Embedding-Generierung bei Abfrage: Kostenlos

• Einziger Kostenfaktor: Erstmalige Indizierung ($0,15 pro 1M Tokens)

Was bedeutet das?

Google vereinfacht den RAG‑Stack für Entwickler. Ein bisher vielschrittiger Prozess wird als verwalteter Dienst in die API verlagert.

Mit sehr niedrigen laufenden Kosten (Speicher, Abfrage) entsteht ein deutlicher Anreiz, die Lösung im Google‑Ökosystem zu betreiben.

📱 Front 2: Die Consumer-Front (Der Apple-Deal)

Parallel zum technischen Angriff auf das Entwickler-Ökosystem hat Google einen strategischen Sieg im Massenmarkt errungen. Apple steht kurz vor dem Abschluss eines Vertrags mit Google.

Die bekannten Deal-Details:

- Kosten: Apple zahlt Google etwa 1 Milliarde US-Dollar pro Jahr

- Leistung: Google liefert ein spezielles 1,2-Billionen-Parameter-Modell

- Zweck: Kernfunktionen (Reasoning, Planning, Weltwissen) der komplett überarbeiteten Siri-Version für 2026

Warum macht Apple das?

Dieser Deal ist ein Eingeständnis, dass Apple im KI-Rennen im Rückstand ist. Das aktuelle interne Cloud-Modell von Apple soll nur etwa 150 Milliarden Parameter haben. Der Google-Deal ist ein „Stopgap" – strategischer Zeitkauf, bis Apples eigene Modelle marktreif sind.

Die entscheidende Frage: Datenschutz

Wie kann Apple (Fokus auf Privacy) ein Google-Modell (Fokus auf Daten) nutzen? Die Deal-Architektur löst diesen Konflikt:

Apples neue KI-Hierarchie:

| Modell-Ebene | Modell | Parameter | Host | Aufgabe |

|---|---|---|---|---|

| On-Device | Apple (In-House) | ~3-10 Mrd. | iPhone/Mac | Schnelle lokale Tasks |

| Apple Cloud | Apple (In-House) | ~150 Mrd. | Apple Server | Standard Cloud-Tasks |

| Premium Cloud | Google (Lizenziert) | 1,2 Billionen | Apple Server | Komplexe Siri-Anfragen |

⚔️ Synthese: Die Zange schließt sich

Googles Ansatz kombiniert zwei Hebel im KI‑Ökosystem:

Unterer Arm der Zange (Developer):

- Kostenloses RAG-System bindet Entwickler

- Start-ups und Unternehmen bauen auf Gemini-Infrastruktur

- Lock-in-Effekt durch wirtschaftliche Unwiderstehlichkeit

Oberer Arm der Zange (Consumer):

- Apple-Deal bringt Gemini auf Milliarden iPhones

- Unsichtbar für Nutzer – Google-Branding nicht sichtbar

- Große Datenmengen für Training (auch wenn anonym)

Warum ist das so effektiv?

OpenAI und Anthropic konzentrieren sich primär auf direkte B2C- und B2B-Märkte. Google umgeht diese Fronten:

- Bei Entwicklern: Nicht durch bessere Modelle, sondern durch bessere Infrastruktur

- Bei Consumern: Nicht durch eigene Apps, sondern durch White-Label-Integration

🔮 Ausblick: Google als Infrastruktur-Anbieter

Google positioniert sich nicht nur als Konkurrent von OpenAI und Anthropic, sondern als fundamentaler KI-Infrastruktur-Anbieter für die gesamte Branche – einschließlich seiner größten Rivalen.

Was das bedeutet:

- Entwickler-Ökosystem: Gemini wird zur Standard-Plattform für RAG-basierte Anwendungen

- Consumer-Reichweite: Gemini erreicht Milliarden Nutzer ohne eigenes Frontend

- Strategische Kontrolle: Google kontrolliert kritische Infrastruktur-Layer

Die Konkurrenz-Reaktion:

OpenAI: Muss entweder RAG-Kosten senken oder durch überlegene Modellqualität differenzieren. Der AWS-Deal (38 Mrd.) zeigt: Sie versuchen eigene Infrastruktur aufzubauen.

Anthropic: Fokus auf Enterprise und Constitutional AI als Differenzierung. Aber: Wenn Entwickler bereits auf Gemini-RAG setzen, wird Migration schwierig.

Apple: Bekommt kurzfristig State-of-the-Art-KI. Langfristig: Abhängigkeit von Google – genau das, was sie vermeiden wollten.

Zusammenfassung: Google adressiert gleichzeitig Developer‑Tooling und Consumer‑Integration. Kosten- und Distributionsvorteile können die Nutzung von Gemini begünstigen; in welchem Maß daraus Abhängigkeiten entstehen, hängt von Implementierungsdetails und Alternativen ab.