📢 Das Update: Veo 3.1 & Ingredients to Video

Im November 2025 hat Google ein Update für sein KI-Videomodell ausgerollt, das die Branche aufhorchen lässt. Veo 3.1 (und die schnellere Variante Veo 3.1 Fast) bringt eine Funktion, die professionelle Kreative seit Monaten fordern: "Ingredients to Video".

Die wichtigsten Fakten

- Die Modelle: Veo 3.1 und Veo 3.1 Fast (optimiert für Geschwindigkeit)

- Verfügbarkeit: Breit ausgerollt in der Gemini App für Endnutzer, in Googles AI-Filmmaking-Plattform "Flow" sowie über die Gemini API und Vertex AI für Entwickler und Unternehmenskunden

- Kernfunktion: "Ingredients to Video" – Nutzer können bis zu drei Referenzbilder hochladen, um Charakter, Stil und Szene getrennt zu steuern

- Zusatzfunktionen: Native Audio-Generierung (Soundeffekte und Dialoge) und "First and last frame"-Kontrolle für nahtlose Übergänge

"With Ingredients to Video, you can now guide Veo 3.1 with multiple reference images – one for character, one for scene, one for style. This gives creators unprecedented control over visual consistency."

— Google DeepMind, Veo 3.1 Launch AnnouncementDie Plattform-Strategie

Google rollt das Update nicht nur auf einer Plattform aus, sondern schafft ein End-to-End-Ökosystem:

Drei Einsatzbereiche

- Consumer (Gemini App): Endnutzer können direkt in der Gemini-App Videos mit Referenzbildern erstellen Quelle

- Profi (Flow-Plattform): Kreative und Filmemacher nutzen die dedizierte Flow-Plattform für erweiterte Features wie Scene Extension und Shot Stacking

- Enterprise (API): Entwickler integrieren Veo 3.1 über die Gemini API und Replicate in ihre eigenen Produkte

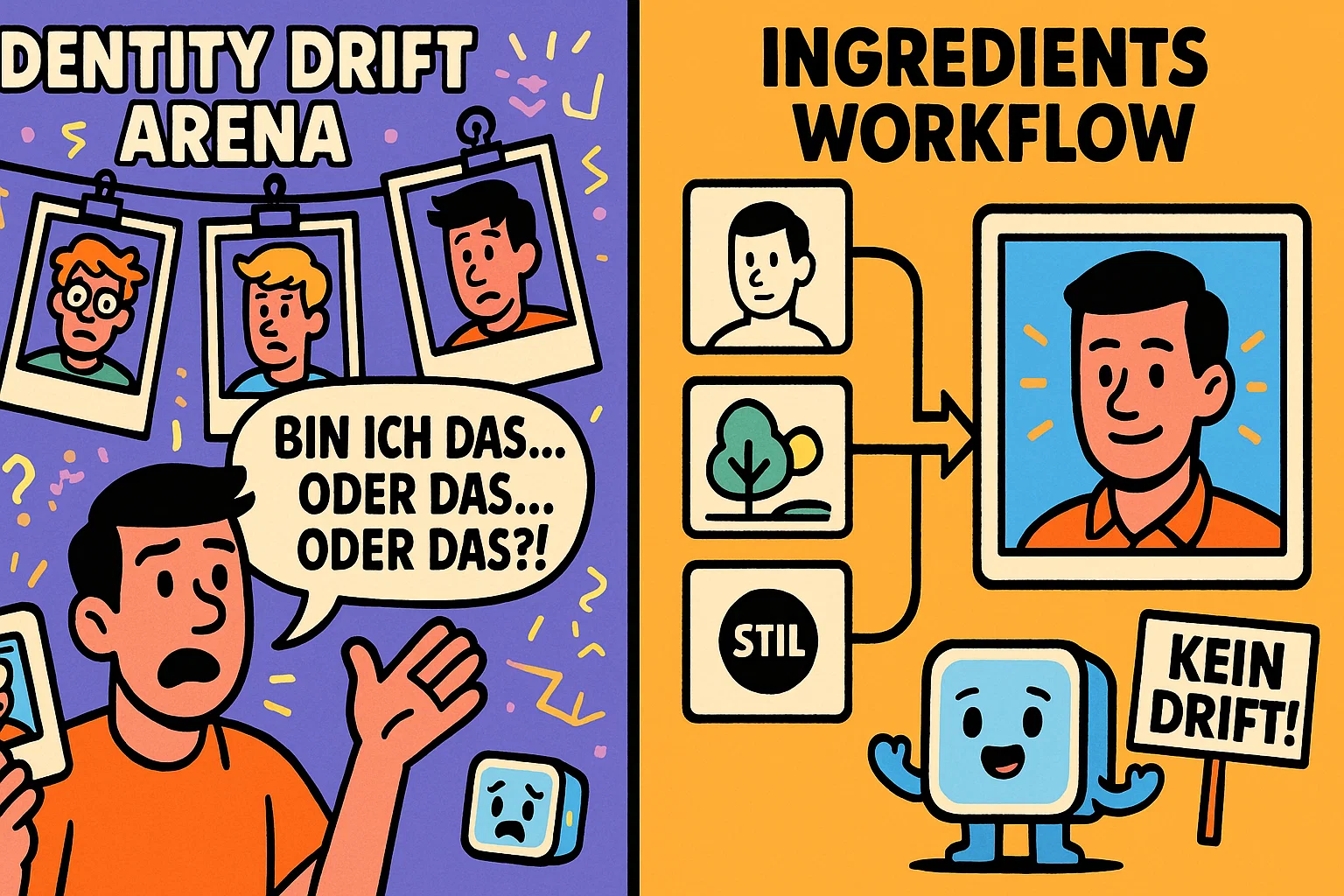

⚠️ Das Problem: Identity Drift

Um zu verstehen, warum "Ingredients to Video" ein Gamechanger ist, muss man das Grundproblem bisheriger KI-Videomodelle verstehen: Identity Drift (Identitätsabweichung).

Was ist Identity Drift?

Stellen Sie sich vor, Sie erstellen per Text-Prompt einen Charakter:

"Eine Frau mit roten Haaren, Brille, grünem Pullover, in einem Café sitzend."

Das Problem: In der nächsten Szene – ebenfalls per Text-Prompt generiert – hat derselbe Charakter plötzlich:

- Blonde Haare statt rote

- Keine Brille mehr

- Einen blauen Pullover statt grün

- Ein anderes Gesicht

Für narrative oder kommerzielle Zwecke (Werbespot, Kurzfilm, Produktvideo) ist diese Inkonsistenz unbrauchbar.

Identity Drift: Der Charakter verliert seine Identität von Szene zu Szene

Warum passiert das?

Das Problem liegt in der Art, wie KI-Modelle Text-Prompts interpretieren. Jeder neue Prompt wird isoliert verarbeitet. Das Modell hat kein "Gedächtnis" dafür, wie der Charakter in der vorherigen Szene aussah.

Selbst wenn Sie schreiben "die gleiche Frau wie vorher" – das Modell muss raten, was "gleich" bedeutet. Es kann die Haarfarbe beibehalten, aber die Gesichtsstruktur ändern. Oder umgekehrt.

Bisherige Workarounds (und warum sie scheitern)

Kreative haben versucht, das Problem mit extrem detaillierten Prompts zu lösen:

"Zeige exakt die gleiche Frau: ovales Gesicht, grüne Augen, Sommersprossen auf der Nase, schulterlanges rotes lockiges Haar, runde Hornbrille, grüner Wollpullover mit V-Ausschnitt..."

Das Problem: Selbst mit 200 Wörtern Beschreibung interpretiert das Modell Details unterschiedlich. "Lockiges Haar" kann mal enge Locken, mal Wellen bedeuten.

Professionelle Studios haben KI-Videos deshalb bisher oft gemieden – zu unzuverlässig für Produktionsumgebungen.

✅ Die Lösung: Feature Disentanglement

Googles "Ingredients to Video" löst das Problem auf fundamental überlegene Weise: durch Feature Disentanglement (Merkmalsentwirrung).

Wie funktioniert "Ingredients"?

Anstatt alles in einem Text-Prompt zu beschreiben, gibt der Nutzer dem Modell separate visuelle Referenzen: Quelle

Die drei "Zutaten" (Ingredients)

1. Charakter-Bild (Character Reference)

Was es macht: Definiert die permanente Identität – Gesicht, Körperstruktur, Hautton

Beispiel: Ein Foto eines spezifischen Gesichts

Garantie: Dieser Charakter bleibt über alle Szenen hinweg identisch

2. Szenen-Bild (Scene Reference)

Was es macht: Definiert den Hintergrund, die Location, die Umgebung

Beispiel: Ein Foto eines Cafés, eines Büros, einer Straße

Garantie: Der Charakter wird in diese Szene gesetzt

3. Stil-Bild (Style Reference)

Was es macht: Definiert den visuellen Look – Beleuchtung, Farbpalette, Kinematografie

Beispiel: Ein Filmstill aus einem 80er-Jahre-Film, ein Aquarell-Gemälde

Garantie: Das gesamte Video wird in diesem Stil gerendert

Das Modell "komponiert" diese drei Elemente zu einer kohärenten Szene.

Der Ingredients-Workflow: Drei separate Referenzen für maximale Kontrolle

Die technische Magie: Feature Disentanglement

Eine technische Analyse von Google Cloud erklärt das zugrundeliegende Problem, das Veo 3.1 löst:

Feature Entanglement – Das alte Problem

Wenn man einem Modell nur ein Referenzbild gibt (z.B. ein Foto einer Person), "verheddert" (entangles) das Modell die permanenten Identitätsmerkmale (Gesichtsstruktur) mit temporären Attributen (Beleuchtung, Pose, Hemdfarbe).

Folge: Das Modell weiß nicht, was es beibehalten soll. Es behält vielleicht die Hemdfarbe bei, verliert aber die Gesichtsidentität – Identity Drift tritt ein.

Googles Lösung: Getrennte Vektoren

Indem der Nutzer getrennte Bilder für Identität, Szene und Stil bereitstellt, kann Veo 3.1:

- Einen robusten "forensischen" Identitäts-Vektor aus dem Charakter-Bild extrahieren (nur die invarianten Merkmale)

- Diesen Vektor in verschiedenen Szenen und Stilen anwenden

- Die temporären Attribute (Beleuchtung, Kleidung) aus dem Kontext der Szene und des Stils ziehen

Das Ergebnis: Perfekte Character Consistency über alle Szenen hinweg.

Live-Demo: Vorher vs. Nachher

Ein YouTube-Video von Google zeigt den Unterschied:

Ohne Ingredients (alter Workflow)

Prompt: "Eine Frau geht durch ein Café, dann sitzt sie, dann steht sie auf."

Ergebnis: Jede Szene zeigt eine andere Frau – andere Haare, anderes Gesicht, andere Kleidung.

Mit Ingredients (neuer Workflow)

Character Image: Foto von Person A

Scene Image: Foto eines Cafés

Style Image: Warme, kinematografische Beleuchtung

Prompt: "Die Person geht, sitzt, steht auf."

Ergebnis: Dieselbe Person über alle drei Szenen hinweg – perfekte Konsistenz.

🎯 Strategische Neuausrichtung: B2B statt Viral

Die Art dieses Updates und die Plattformen, auf denen es ausgerollt wird, offenbaren eine klare strategische Neuausrichtung bei Google.

OpenAI wants Social, Google wants Professional

Ein Reddit-Nutzer brachte es auf den Punkt:

"OpenAI wants social (virale Demos) and Google wants professional (produktionsreife Tools)."

Während OpenAI mit Sora auf Wow-Momente und virale Verbreitung setzt, zielt Google auf Kontrolle, Nutzen und Workflow.

Die Zielgruppe: Nicht Consumer, sondern B2B

Der wichtigste Rollout-Ort ist nicht nur die Gemini App für Endnutzer, sondern:

- Flow-Plattform: Googles dedizierte AI-Filmmaking-Suite für Kreativprofis

- Gemini API: Für Entwickler, die Veo in ihre eigenen Produkte integrieren

- Vertex AI: Für Enterprise-Kunden mit hohen Compliance-Anforderungen

Das Signal ist klar: Google verkauft nicht an Teenager, die auf TikTok virale Clips posten wollen. Google verkauft an:

- Werbeagenturen, die konsistente Charaktere in Spots brauchen

- Filmstudios, die Pre-Viz und Storyboarding automatisieren wollen

- Marketing-Abteilungen, die Produktvideos skaliert produzieren müssen

Die Feature-Prioritäten verraten die Strategie

Die neuen Features – Ingredients, First/Last Frame, Scene Extension – sind keine Spielereien, sondern Post-Production-Werkzeuge:

Professionelle Workflow-Features

- Ingredients: Character Consistency für narrative Formate

- First/Last Frame: Nahtlose Übergänge zwischen Szenen (wichtig für Schnitt)

- Scene Extension: Clips verlängern ohne Qualitätsverlust (wichtig für Timing)

- Native Audio: Soundeffekte und Dialoge direkt generiert (spart Post-Production-Zeit)

Das sind keine Features, die man für 5-Sekunden-Memes braucht. Das sind Features, die man für 30-Sekunden-Werbespots braucht.

Google vs. Adobe: Der kommerzielle Sicherheitsvorteil

Google positioniert sich – ähnlich wie Adobe mit seinen Firefly-Tools – als Anbieter für kommerziell sichere KI-Tools.

Das bedeutet:

- Kein Training auf urheberrechtlich geschütztem Material (wie bei Sora vermutet)

- Klare Lizenzierung für kommerzielle Nutzung

- Compliance mit EU AI Act und GDPR

Für Unternehmen ist das ein entscheidender Vorteil: Sie können Veo-generierte Videos in Werbekampagnen nutzen, ohne rechtliche Grauzone.

Googles strategische Neuausrichtung: Von Consumer-Viral zu Professional-B2B

⚖️ Chancen, Risiken & Ausblick

Chancen: Google etabliert sich als Enterprise-Standard

- Millionenschwere Werbebranche: Agenturen brauchen konsistente Charaktere – Veo 3.1 liefert das als einziges Modell Quelle

- API-Einnahmen: Statt einmaliger Consumer-Payments generiert Google wiederkehrende B2B-Einnahmen

- Ökosystem-Lock-In: Wer Flow + Gemini API + Vertex AI nutzt, bleibt im Google-Ökosystem

- Regulierungs-Vorteil: Google erfüllt EU AI Act-Anforderungen früher als Konkurrenten

Risiken: Verlust der Consumer-Dynamik

- Viral-Verlust: OpenAI Sora und chinesische Tools (Kling) dominieren Social Media mit "magischen" Demos Quelle

- Komplexität-Barriere: "Drei Bilder hochladen" ist komplexer als "Text eingeben" – Consumer könnten abgeschreckt sein

- Flow-Paywall: Die besten Features sind hinter teuren Enterprise-Lizenzen versteckt Quelle

Der neue Standard: Multimodale Inputs

Text-allein-Prompts für die Videoproduktion sind damit für professionelle Anwendungen veraltet. Der neue "Goldstandard" ist:

Die neue Video-Prompt-Formel

Text-Prompt (Was passiert) + Referenzbilder (Charakter/Szene/Stil) + Optional: Audio (Soundscape) = Produktionsreifes Video

Wettbewerbsdruck auf OpenAI & Anthropic

Der Wettbewerbsdruck steigt massiv:

- OpenAI (Sora): Muss schnell "Character Consistency"-Features nachliefern, sonst verlieren sie Enterprise-Kunden

- Runway, Pika Labs: Kleinere Player müssen ähnliche Konsistenz-Kontrollen integrieren, um relevant zu bleiben

- Adobe Firefly Video: Direkter Konkurrent im B2B-Markt – Google hat mit Veo 3.1 die Nase vorn Quelle

Ausblick: Integration in die Google-Cloud-Infrastruktur

Googles langfristige Strategie wird deutlich:

- Phase 1 (jetzt): Veo 3.1 als Standalone-Tool etablieren

- Phase 2 (2026): Integration in Google Workspace (Veo-Videos direkt in Google Slides, Docs)

- Phase 3 (2027+): Veo als Standard-Komponente von YouTube Creator Studio

Das Endziel: KI-Video-Generierung als Standard-Feature in allen Google-Produkten – genauso wie heute "Rechtschreibprüfung" überall Standard ist.

Bottom Line

Veo 3.1 mit "Ingredients to Video" ist mehr als ein Feature-Update – es ist ein strategisches Statement. Während die Konkurrenz auf virale "Magie" setzt, setzt Google auf kontrollierbare, produktionsreife Werkzeuge. Die Wette: In einem Markt, der zunehmend von Compliance, Konsistenz und kommerzieller Sicherheit getrieben wird, gewinnt nicht das "magischste", sondern das zuverlässigste Tool. Google baut nicht das KI-Video-Tool für TikTok – Google baut das KI-Video-Tool für die Fortune 500.