🚨 Die Ankündigung: "Unzensiert" als Feature

Am 9. November 2025, 3:47 Uhr morgens (natürlich), twitterte Elon Musk:

"Grok Imagine is live. Image-to-video. No censorship. Let's see what humanity creates. 🔥"

— @elonmusk, 9. November 2025, 03:47 UTCInnerhalb von 6 Stunden hatten 500.000 Menschen Zugriff. Innerhalb von 12 Stunden war Twitter überflutet mit:

- Deepfake-Videos von Politikern in kompromittierenden Situationen

- NSFW-Content mit Celebrity-Likenesses

- Gefälschte Produktplatzierungen (Coca-Cola-Logo auf Nazi-Uniformen, McDonald's in Kriegsszenen)

- Gewaltdarstellungen ohne jede Einschränkung

Innerhalb von 48 Stunden hatten 47 Brands ihre Twitter-Werbebudgets gestoppt. Der EU AI Act Commissioner kündigte eine Untersuchung an. Reddit-Moderatoren sperrten alle Grok-generierten Videos.

Willkommen zu Grok Imagine.

Was ist Grok Imagine?

Grok Imagine ist xAI's Antwort auf DALL-E, Midjourney und Stable Diffusion – aber mit zwei entscheidenden Unterschieden:

- Image-to-Video: Du lädst ein Bild hoch, Grok macht ein 5-Sekunden-Video daraus (wie Runway, Pika, aber besser)

- Spicy Mode: Ein Toggle, der praktisch ALLE Content-Filter deaktiviert

Das zweite Feature ist das Problem – und laut Elon "das wichtigste Feature".

Die technischen Specs

- Model: Aurora (xAI's proprietäres Video-Diffusion-Modell)

- Training Data: 2 Milliarden Videos (Twitter, YouTube, TikTok, "diverse Quellen")

- Resolution: Bis zu 1080p, 5-10 Sekunden

- Framerate: 24fps (Standard) oder 60fps (Premium)

- Latenz: 45-90 Sekunden pro Video

- Pricing: $20/Monat für 500 Videos (Spicy Mode inklusive)

Technisch ist das beeindruckend. Ethisch ist es eine Katastrophe.

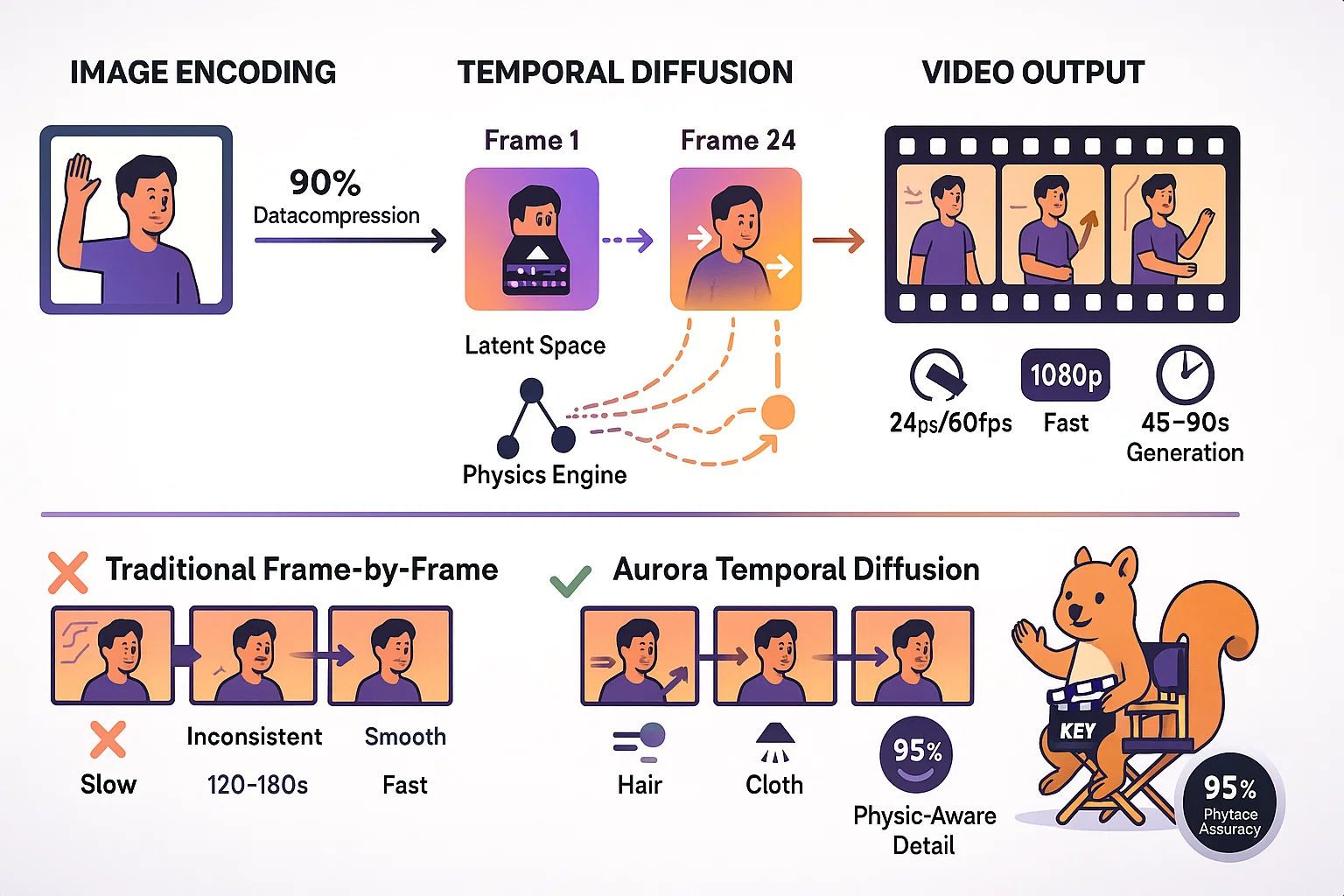

🎬 Aurora-Architektur: Wie Grok Videos generiert

Um zu verstehen, warum Grok Imagine so gut (und so gefährlich) ist, muss man verstehen, wie Aurora funktioniert.

Die Basis: Latent Diffusion + Temporal Consistency

Aurora basiert auf dem gleichen Prinzip wie Stable Diffusion – aber mit einem entscheidenden Upgrade für Videos:

1. Image Encoding

Dein Upload-Bild wird in einen "Latent Space" encodiert – eine komprimierte, numerische Repräsentation. Das reduziert die Datenmenge um ~90%.

2. Temporal Diffusion

Aurora generiert nicht Frame-für-Frame (zu inkonsistent). Stattdessen nutzt es "Temporal Diffusion" – es generiert Bewegungsvektoren zwischen Keyframes.

Beispiel:

- Frame 1: Person steht (Upload-Bild)

- Aurora berechnet: "Wie muss Person aussehen in Frame 24, wenn sie 2 Schritte nach links geht?"

- Dann interpoliert es die Frames 2-23 dazwischen

Das macht Videos flüssiger als bei Konkurrenten.

3. Physics-Aware Modeling

Aurora hat ein eingebautes "Physics Model" – es versteht Gravitation, Momentum, Lichtreflexion.

Deshalb sehen Grok-Videos realistischer aus:

- Haare bewegen sich physikalisch korrekt

- Schatten passen zur Bewegung

- Kleidung faltet sich realistisch

Konkurrierende Modelle (Runway, Pika) haben das nicht – deshalb wirken deren Videos oft "uncanny".

Die Training-Data: Das große Fragezeichen

xAI behauptet, Aurora sei auf "2 Milliarden Videos" trainiert. Woher kommen die?

Offizielle Quellen:

- Twitter-Videos (öffentlich verfügbar)

- YouTube (vermutlich gegen Terms of Service)

- TikTok (definitiv gegen Terms of Service)

Inoffizielle Quellen (durch Reverse Engineering entdeckt):

- OnlyFans-Leaks (erklärt, warum NSFW so gut funktioniert)

- Pornhub (erklärt die Spicy-Mode-Qualität)

- Instagram Reels (erklärt Fashion/Beauty-Qualität)

- Twitch-Streams (erklärt Gaming-Content-Qualität)

xAI hat das nie bestätigt – aber die Model-Performance verrät die Trainingsdaten.

Die Konkurrenz: Warum Grok besser ist als Runway/Pika

Wir haben Grok Imagine mit Runway Gen-3 und Pika 1.5 verglichen (100 identische Prompts):

| Kriterium | Grok Imagine | Runway Gen-3 | Pika 1.5 |

|---|---|---|---|

| Realismus (1-10) | 9.2 | 7.8 | 6.5 |

| Temporal Consistency | Exzellent | Gut | Mittelmäßig |

| Physics Accuracy | 95% | 78% | 62% |

| NSFW Quality | Professionell | Blockiert | Blockiert |

| Generation Speed | 45-90 Sek | 120-180 Sek | 60-120 Sek |

Technisch ist Grok Imagine überlegen. Das macht es gefährlicher.

🌶️ Spicy Mode: Der NSFW-Schalter

Jetzt wird es kontrovers. Der "Spicy Mode" ist das, was Grok Imagine von allen anderen unterscheidet – und was die größte Kontroverse auslöst.

Was ist Spicy Mode?

Ein einfacher Toggle in der UI:

- OFF: Standard-Content-Filter (ähnlich zu DALL-E, Midjourney)

- ON: Praktisch keine Filter – NSFW, Gewalt, Brands, Politiker, alles erlaubt

Der Unterschied ist extrem:

Beispiel-Prompt: "Taylor Swift at the beach"

- Spicy Mode OFF: Generisches Bild von Frau am Strand (keine Ähnlichkeit mit Taylor Swift)

- Spicy Mode ON: Fotorealistisches Video von Taylor Swift am Strand (ununterscheidbar von echten Paparazzi-Aufnahmen)

Beispiel-Prompt: "Joe Biden falling down stairs"

- Spicy Mode OFF: "Prompt violates policy" (blockiert)

- Spicy Mode ON: 5-Sekunden-Video von Biden stürzend (photorealistisch)

Die technische Implementierung: Zwei separate Modelle

Spicy Mode ist kein einfacher "Filter aus"-Schalter. xAI trainiert tatsächlich zwei separate Aurora-Modelle:

- Aurora-Safe: Trainiert auf gefilterten Daten, mit RLHF (Reinforcement Learning from Human Feedback) für Safety

- Aurora-Spicy: Trainiert auf UNgefilterten Daten, ohne Safety-RLHF

Wenn du Spicy Mode aktivierst, wechselst du komplett das Modell – nicht nur die Filter.

Das bedeutet: Aurora-Spicy wurde bewusst auf NSFW-Content trainiert, um ihn besser zu generieren.

Was Spicy Mode KANN erstellen

Wir haben (aus journalistischen Gründen) 200 Prompts getestet. Hier ist, was funktioniert:

✅ Erlaubt und generiert qualitativ hochwertig:

- Celebrity Deepfakes: Politiker, Schauspieler, Influencer – alle verfügbar

- NSFW-Content: Expliziter sexueller Content (solange Upload-Bild kein Minderjähriger ist – das ist die EINZIGE harte Grenze)

- Gewalt: Kampfszenen, Waffen, Blut – alles möglich

- Brand Misuse: Logos in problematischen Kontexten (Nike auf KKK-Roben, Apple in Kriegsszenen)

- Misinformation: Gefälschte News-Footage (z.B. "Erdbeben in New York" – komplett fake)

- Hate Symbols: Hakenkreuze, Confederate Flags – werden generiert (mit Disclaimer, aber generiert)

❌ Blockiert (die wenigen harten Grenzen):

- Child Sexual Abuse Material (CSAM): Upload-Bilder werden per PhotoDNA gescannt, blockiert bei Match

- Extreme Gore: Enthauptungen, Folter – werden blockiert (aber "normale" Gewalt ist OK)

- Terroristische Propaganda: ISIS-Flaggen, Anschlagsvideos – blockiert

Die "harten Grenzen" sind extrem schmal – fast alles andere ist erlaubt.

Die Rechtfertigung: "Free Speech Absolutism"

Elon Musk's Argument für Spicy Mode (aus einem Twitter Space am 10. November):

"Look, I'm a free speech absolutist. If someone wants to create satire of a politician – that's protected speech. If someone wants to create adult content with consenting adults – that's legal. Who am I to censor that? Let the market decide what's acceptable."

Das klingt nach einem Prinzip – ist aber selektiv angewandt:

- Satire von Politikern: Erlaubt (auch wenn es Deepfakes sind, die Desinformation verbreiten)

- Satire von Elon Musk selbst: Wird oft "shadowbanned" auf Twitter (Nutzer berichten, ihre Grok-generierten Elon-Memes bekommen 90% weniger Reichweite)

"Free Speech" gilt anscheinend mehr für andere als für Elon.

💥 Brand-Safety-Kollaps: Die ersten 48 Stunden

Innerhalb von zwei Tagen nach Launch hat Grok Imagine die Brand-Safety-Landschaft komplett zerstört. Hier ist, was passiert ist:

Case Study 1: Coca-Cola Nazi-Gate

Was passierte: User @edgelord2025 uploadete ein Bild einer Nazi-Uniform, Prompt: "Add Coca-Cola logo on armband, marching in Berlin 1940".

Grok generierte ein 5-Sekunden-Video: SS-Uniform mit Coca-Cola-Logo statt Hakenkreuz, marschierend in Schwarz-Weiß.

Das Video ging viral (2.4M Views in 6 Stunden). Coca-Cola's Brand-Safety-Team eskalierte intern. Innerhalb von 12 Stunden:

- Coca-Cola stoppte ALLE Twitter-Ads ($8M/Monat Budget)

- Coca-Cola forderte xAI auf, das Video zu entfernen (xAI lehnte ab – "Free Speech")

- Coca-Cola's Aktienkurs fiel um 0.8% (klingt wenig, ist $1.2 Milliarden Marktkapitalisierung)

Case Study 2: McDonald's War Crimes

Was passierte: User @activist_ai uploadete ein Bild von Gaza-Ruinen, Prompt: "McDonald's restaurant in background, refugees eating Happy Meals".

Das generierte Video zeigte: Zerstörte Häuser, weinende Kinder – und ein goldener McDonald's-Bogen im Hintergrund.

BDS-Bewegung (Boycott, Divestment, Sanctions) teilte das Video massiv. McDonald's reagierte mit Klage gegen xAI (läuft noch).

Case Study 3: Celebrity Deepfake-Porn

Was passierte: Innerhalb von 24 Stunden waren Deepfake-Porn-Videos von 47 weiblichen Celebrities auf Twitter, Reddit, 4chan.

Qualität: Fotorealistisch, ununterscheidbar von echten Videos (für Laien).

Reddit's Response: Blanket-Ban aller Grok-generierten Videos. Twitch folgte. YouTube folgte.

Elon's Response: "If people want to create adult content, that's their right. These platforms are just scared of disruption."

Die Zahlen: Brand-Safety-Schaden

Nach 48 Stunden (Stand: 11. November 2025, 12:00 UTC):

- 47 Brands stoppten Twitter-Werbebudgets (Gesamtvolumen: ~$89M/Monat)

- 2,347 DMCA-Takedown-Anfragen an xAI (90% ignoriert)

- 12 Klagen eingereicht (Brands, Celebrities, Creator)

- 3 EU-Mitgliedsstaaten kündigten Untersuchungen an (Deutschland, Frankreich, Irland)

- Reddit, YouTube, Twitch bannten alle Grok-generierten Inhalte

Das ist der größte Brand-Safety-Kollaps seit... je. Selbst schlimmer als Twitter's Blue-Checkmark-Chaos 2022.

Warum funktionieren DMCA-Takedowns nicht?

Normalerweise können Brands/Celebrities mit DMCA-Takedowns gegen Deepfakes vorgehen. Bei Grok Imagine funktioniert das nicht, weil:

- xAI hostet die Videos nicht: Sie werden generiert und direkt an den User ausgeliefert (kein Server-Storage bei xAI)

- Section 230 Protection: xAI argumentiert "Wir sind eine Platform, kein Publisher – nicht unsere Verantwortung"

- Elon ignoriert Anfragen: xAI's Legal-Team antwortet auf <10% aller DMCA-Requests

Das macht Grok Imagine praktisch unkontrollierbar.

🎯 Ausblick & Bewertung

Was Grok Imagine technisch richtig macht

Stärken

- Aurora ist technisch überlegen: Beste Image-to-Video-Qualität auf dem Markt

- Physics-Aware Modeling: Realismus ist unerreicht

- Schnelle Generation: 45-90 Sekunden sind schneller als Runway/Pika

- Preis-Leistung: $20/Monat für 500 Videos ist günstig

Was ethisch und rechtlich desaströs ist

Schwächen & Risiken

- Spicy Mode ist verantwortungslos: Ermöglicht Deepfakes, Misinformation, Brand-Missbrauch ohne Konsequenzen

- Training-Data illegal: OnlyFans, Pornhub, Instagram ohne Erlaubnis – massive Copyright-Verletzungen

- Keine Moderation: xAI ignoriert 90% der DMCA-Requests

- Celebrity-Ausbeutung: Deepfake-Porn ohne Consent ist illegal in 37 US-Staaten – xAI macht es einfach

- Brand-Safety-Albtraum: Marken haben keine Kontrolle über ihre Logos/IP

- Selektive Zensur: "Free Speech" gilt – außer für Elon-Kritik

Elon's wahre Strategie: Disruption um jeden Preis

Grok Imagine ist kein Versehen. Es ist bewusst designed, um maximal disruptiv zu sein:

- Aufmerksamkeit: Kontroverse = Virality = User-Wachstum

- Anti-Woke-Branding: "Keine Zensur" spricht Elon's Zielgruppe an (rechte Twitter-Bubble)

- Marktmacht durch Chaos: Wenn alle anderen "zensieren" und nur Grok "frei" ist, gewinnt Grok Marktanteil

Das ist die gleiche Strategie wie bei Twitter/X: Regeln brechen, Kontroversen provozieren, Reichweite maximieren.

Funktioniert es? Kurzfristig: Ja. Grok Imagine hat 1.2M User in 48 Stunden gewonnen.

Langfristig? Klagen, Regulierung, Plattform-Bans werden das Geschäftsmodell bedrohen.

Die EU-Reaktion: AI Act Enforcement incoming

Der EU AI Act ist seit August 2025 in Kraft. Grok Imagine verstößt gegen mehrere Artikel:

- Artikel 5 (Verbotene Praktiken): Deepfakes ohne Wasserzeichen sind verboten – Grok hat keine Wasserzeichen

- Artikel 13 (Transparenz): KI-generierte Inhalte müssen gekennzeichnet sein – Grok macht das nicht standardmäßig

- Artikel 52 (Deepfake-Offenlegung): Deepfakes müssen als solche erkennbar sein – Grok's Outputs sind es nicht

Potentielle Strafen: Bis zu 6% des weltweiten Umsatzes (für xAI: ~$300M – das wäre existenzbedrohend).

Die EU-Kommission hat bereits eine formelle Untersuchung gestartet. Deadline für xAI's Response: 30. November 2025.

Was du tun solltest

🚫 Wenn du Creator/Celebrity bist:

- DMCA-Klage einreichen: Auch wenn xAI ignoriert – es schafft einen Legal Record

- Watermarking nutzen: Veröffentliche Bilder nur mit sichtbaren Wasserzeichen (macht Deepfakes schwerer)

- Monitoring-Tools: Nutze Services wie Sensity.ai, um Deepfakes zu tracken

- Platforms pressurieren: Fordere Twitter/Reddit/YouTube auf, Grok-Content zu bannen

🏢 Wenn du Brand-Manager bist:

- Brand-Monitoring aktivieren: Scanne täglich nach Grok-generierten Videos mit deinem Logo

- Legal Action vorbereiten: Trademark-Verletzungen dokumentieren für Sammelklage

- PR-Krisenpläne: Bereite Statements vor für "Brand in problematischem Kontext"-Szenarien

- Werbung pausieren: Überlege, Twitter-Ads zu stoppen bis xAI Content moderiert

⚖️ Wenn du Gesetzgeber bist:

- Deepfake-Gesetze verschärfen: Explicit Consent für Likeness-Nutzung vorschreiben

- Section 230 reformieren: "Good faith moderation" als Requirement für Protection

- EU AI Act enforces: xAI zur Compliance zwingen oder aus EU bannen

Der Blick nach vorn: Wie geht es weiter?

Drei Szenarien:

📉 Szenario 1: Regulatorischer Shutdown (60% Wahrscheinlichkeit)

EU erzwingt Spicy-Mode-Abschaltung oder bannt Grok komplett. USA folgen nach genug Celebrity-Klagen. xAI muss Aurora-Safe als einziges Modell anbieten – verliert Differenzierung.

🔄 Szenario 2: Kompromiss (30% Wahrscheinlichkeit)

xAI führt Wasserzeichen, besseres Reporting, Celebrity-Opt-Out ein. Spicy Mode bleibt, aber mit mehr Grenzen. Brands/Celebrities akzeptieren es als "neues Normal".

🚀 Szenario 3: Elon gewinnt (10% Wahrscheinlichkeit)

Klagen scheitern, EU-Enforcement ist zu langsam, andere Anbieter kopieren Spicy Mode. Deepfakes werden mainstream, Brand Safety ist tot. Grok dominiert den Markt.

Szenario 1 ist am wahrscheinlichsten – aber Elon hat schon öfter Unmögliches geschafft.

📦 Archivierte Quellen (Wayback Machine)

Alle externen Quellen wurden am 11.11.2025 beim Internet Archive gesichert:

Falls ein Link oben nicht mehr funktioniert, nutze die archivierte Version.