🧠 Was ist "Frame-Aware Reasoning"?

Stell dir vor, du willst einer KI erklären, was in einem kurzen Clip passiert. Normalerweise müsstest du ihr das ganze Video zeigen.

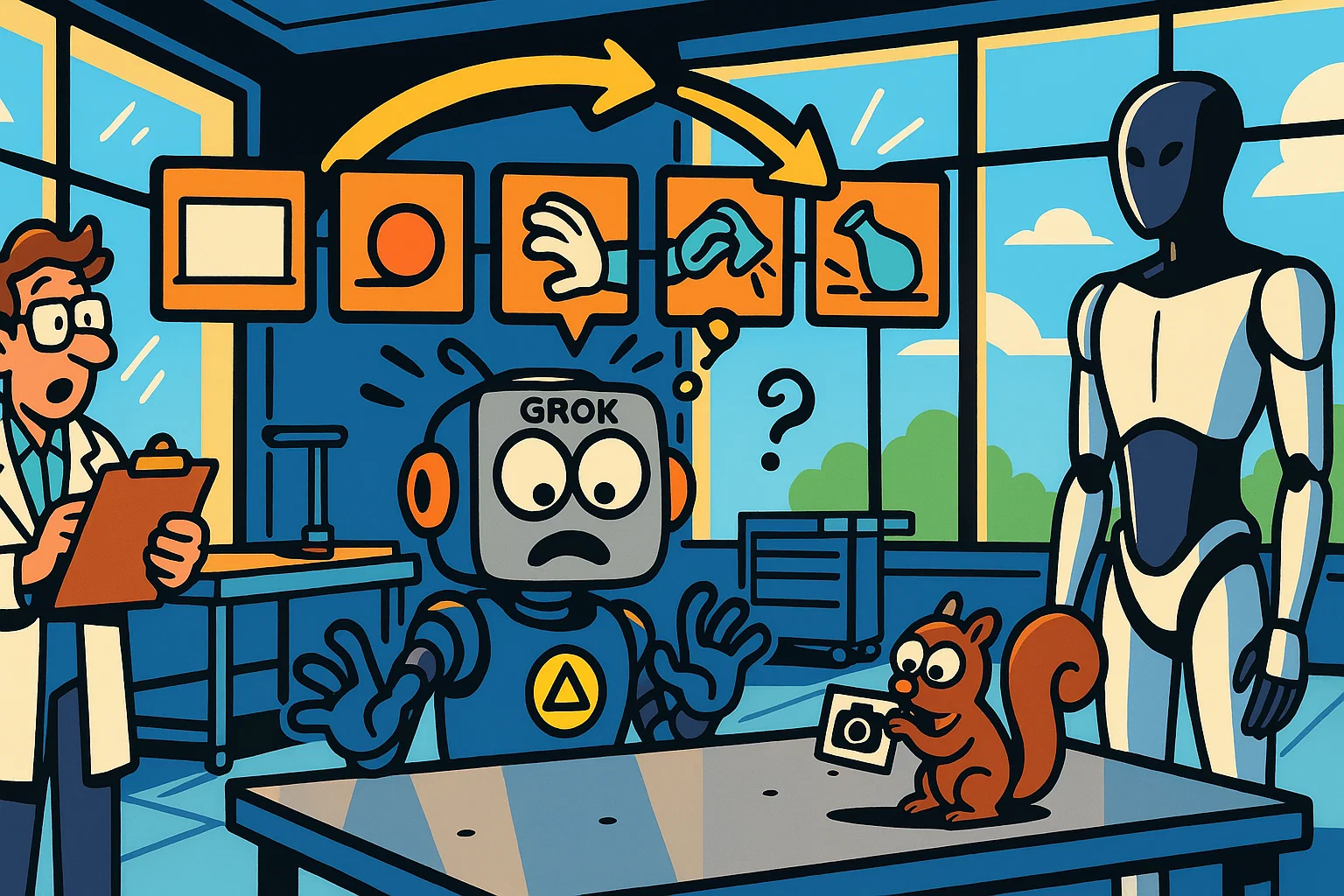

Frame-Aware Reasoning (FAR) ist anders: Du zeigst der KI nur eine Handvoll wichtiger Standbilder (Key-Frames) aus dem Clip.

Beispiel: Statt eines 10-Sekunden-Videos, wie ein Ball rollt, zeigst du nur:

- Bild 1: Ball ist links.

- Bild 2: Ball ist in der Mitte.

- Bild 3: Ball ist rechts.

Grok vergleicht diese Bilder und schlussfolgert: "Der Ball hat sich von links nach rechts bewegt." Es versteht den Prozess, ohne das Video gesehen zu haben.

⚡ Warum ist das so clever? Die 80/20-Regel

Echte Videoverarbeitung ist extrem teuer und langsam. Hunderte von Bildern müssen analysiert werden.

Frame-Aware Reasoning ist ein pragmatischer Kompromiss:

- 80% des Verständnisses: Für die meisten Aufgaben reicht es zu wissen, *dass* sich etwas geändert hat, nicht *wie* genau in jeder Millisekunde.

- 20% der Kosten: Nur 5-10 Bilder statt 300 zu analysieren, spart massiv Rechenzeit und Geld.

Es ist eine "gut genug"-Lösung, die in der Praxis oft besser ist als die perfekte, aber teure Alternative.

Der Prozess: Statt eines ganzen Videos analysiert Grok nur wenige Schlüsselbilder (Key-Frames) und leitet daraus die Handlung ab.

🤖 Warum ist das perfekt für Roboter?

Ein humanoider Roboter wie der Tesla Optimus kann nicht ständig 4K-Videos in die Cloud streamen, um seine Umgebung zu verstehen. Das wäre zu langsam und würde zu viel Energie kosten.

Mit Frame-Aware Reasoning braucht er das nicht. Er kann:

- Navigieren: Ein Bild pro Sekunde reicht, um zu sehen, wo er ist.

- Handeln: Um eine Tasse zu greifen, reichen 3-4 Bilder: "Hand nähert sich", "Hand berührt", "Hand greift".

- Effizient sein: Er muss nur dann mehr Bilder analysieren, wenn sich etwas Wichtiges ändert.

Diese Technologie ist der Schlüssel, um Robotern ein effizientes, visuelles Verständnis der Welt zu geben.

🎯 Warum ist das wichtig?

Für normale Nutzer:

- Intelligentere Analyse von Fotostrecken: Grok kann "Vorher/Nachher"-Bilder oder Event-Fotos als Geschichte verstehen.

- Schnellere Video-Zusammenfassungen: Gib Grok ein paar Screenshots und es erklärt dir, was im Video passiert.

Für die KI-Industrie:

xAI wählt eine andere Strategie als Google oder OpenAI. Statt auf teure "Full-Video"-Modelle zu setzen, fokussieren sie sich auf eine pragmatische, effiziente Lösung, die perfekt auf die Bedürfnisse von Robotik und autonomen Agenten zugeschnitten ist. Es ist ein schlanker, fokussierter Ansatz.

⚠️ Gibt's auch Probleme?

Ja, die Methode hat klare Grenzen:

- Schnelle Aktionen werden übersehen: Alles, was zwischen zwei Schlüsselbildern passiert, sieht die KI nicht.

- Kein Audio: Das Modell ist "taub". Es kann Geräusche nicht mit visuellen Ereignissen verknüpfen.

- Nicht für Details: Für eine detaillierte Filmanalyse oder Sport-Kommentierung ist die Methode ungeeignet.

📊 Fazit: Pragmatismus siegt

Das Wichtigste: Grok Vision 2.2 ist keine "bessere" Video-KI, sondern eine intelligentere Implementierung für spezifische Probleme. xAI fragt nicht "Wie können wir Videos verstehen?", sondern "Was ist der günstigste Weg, um Veränderung zu verstehen?". Die Antwort ist Frame-Aware Reasoning – eine Technologie, die wie maßgeschneidert für die nächste Generation von Robotern und Agenten ist.