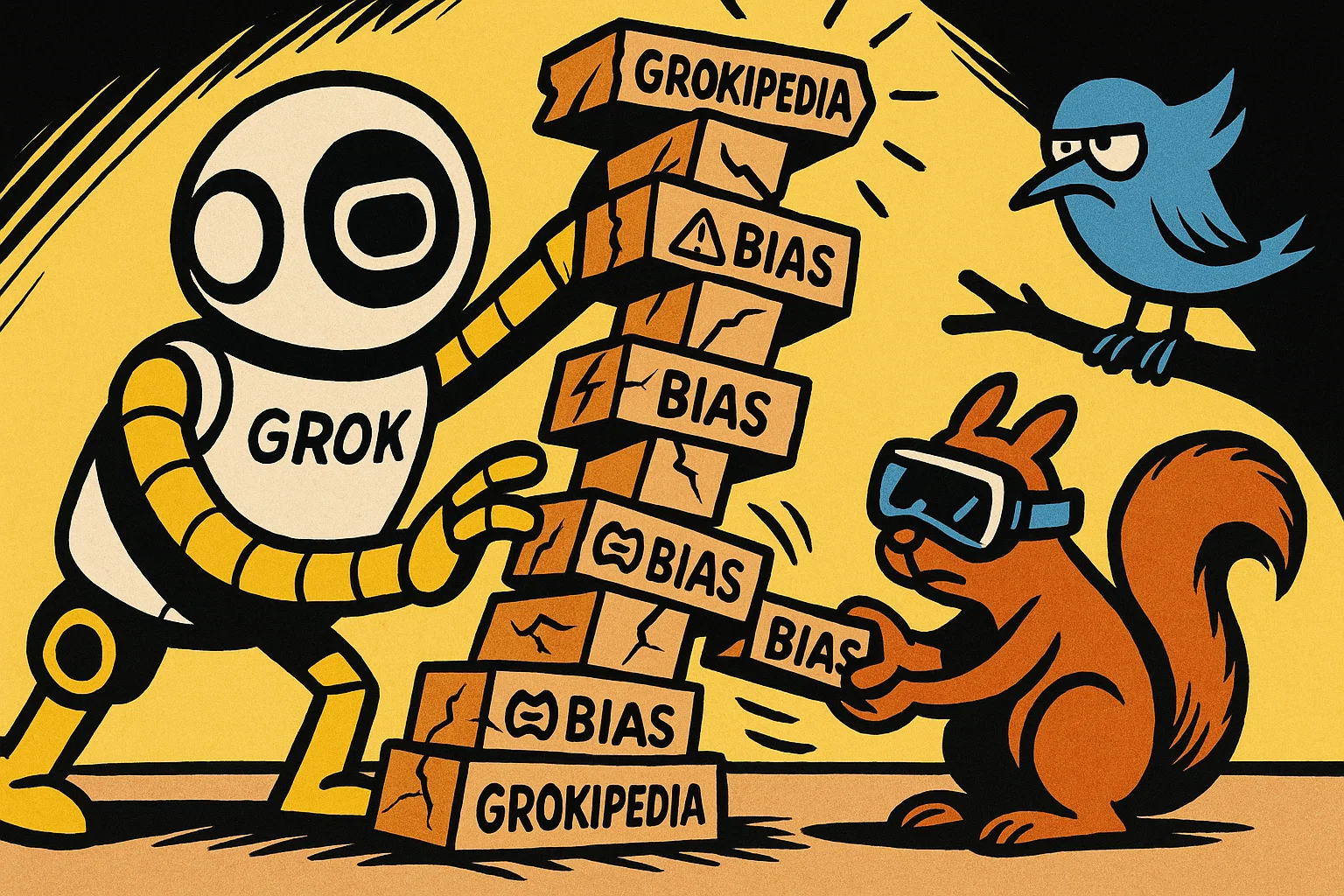

🧠 Die Idee hinter Grokipedia

Grokipedia soll eine Art Wikipedia sein – aber statt von Tausenden freiwilligen Autoren geschrieben, erstellt die KI Grok alle Artikel selbst. Das Versprechen: Schneller, aktueller und ohne die endlosen Diskussionen, die es bei Wikipedia manchmal gibt.

Aber genau hier liegt das Problem: Bei Wikipedia kann jeder mitschreiben und korrigieren. Es gibt Transparenz, Quellenangaben und Diskussionsseiten. Bei Grokipedia entscheidet allein die KI – und die wurde von xAI trainiert.

⚠️ Das Problem: Einseitige Perspektiven

Jede KI ist nur so neutral wie die Daten, mit denen sie trainiert wurde. Grok wurde unter anderem mit Beiträgen von der Plattform X (früher Twitter) trainiert – einer Plattform, auf der bestimmte politische Meinungen stark vertreten sind.

Das Ergebnis: Grok neigt dazu, manche Themen aus einer bestimmten Sichtweise darzustellen. Das nennt man „algorithmischen Bias" – also systematische Verzerrungen, die durch die Datenauswahl entstehen.

Ein Beispiel: Wenn Grok einen Artikel über Klimawandel schreibt, könnte er überproportional viele skeptische Quellen zitieren – nicht weil das der wissenschaftliche Konsens ist, sondern weil solche Meinungen in den Trainingsdaten häufig vorkamen.

🚨 Warum das gefährlich werden kann

Wenn eine KI-Wissensplattform zur Hauptquelle für Informationen wird, hat der Betreiber enorme Macht. Er kann beeinflussen, was als „wahr" gilt – ohne dass Nutzer das merken.

Bei Wikipedia ist das anders: Dort sieht man in der Versionsgeschichte, wer was geändert hat. Man kann diskutieren und korrigieren. Bei Grokipedia ist das nicht möglich. Die KI gibt eine Antwort, und die scheint „objektiv" – ist es aber nicht.

Das nennt man auch „Echokammer": Ein System, in dem nur noch bestimmte Meinungen verstärkt werden, während andere ausgeblendet bleiben. Für eine Wissensplattform ist das das Gegenteil von dem, was sie sein sollte.

💡 Was das bedeutet

Grokipedia ist ein Experiment – und es zeigt, wie wichtig Transparenz bei KI-Systemen ist. Wenn wir nicht wissen, wie die KI zu ihren Antworten kommt, können wir auch nicht beurteilen, ob sie fair und ausgewogen ist.

Das gilt nicht nur für Grokipedia. Auch andere KI-Wissensplattformen (von Google, OpenAI oder anderen) stehen vor diesem Problem. Die Frage ist: Wer kontrolliert das Wissen? Und wie stellen wir sicher, dass KI nicht zur Meinungsmaschine wird?